Für mehrere Aktionen im Sommer 2025 habe ich ein interaktives Kunstwerk geschaffen. „The Circle of life/lAIf“ ist ein Zyklus-Zyklus, der sich in fünf Prosatexten mit zyklischen Elementen unserer Existenz beschäftigt. Zusätzlich gibt es eine KI-Komponente, eine Visualisierung und eine Interaktionsmöglichkeit. Das Gesamtkunstwerk wird also von mir angestoßen, nimmt aber auch Impulse der Maschine und des Publikums auf, sodass es interaktive Kunst ist. Die Präsentationsform ist erstmal eine Textsammlung, auf Papier bzw am Display. Dann wird dieser Textkorpus als Audio gelesen und zur besseren Rezeption visualisiert. Dann wird sie eine visuelle Präsentation bei einem Event vor Ort, wirkt auf Menschen, die darauf reagieren. Diese Reaktionen werden zu Bildern und im letzten Schritt werden aus den Bildern Videos, die Publikumsreaktionen im Laufe des Projektes verbinden. An jeder Stelle des Prozesses kann ich als Künstler eingreifen, lasse aber auch einen Freiraum für Flow, Entwicklung und das, was ich nicht kontrollieren kann. Nur im Notfall greife ich moderierend ein oder behebe technische Pannen. Ansonsten lasse ich den Dialog zwischen KI und Publikum einfach laufen. Über den Inhalt werde ich später berichten, hier erstmal ein technischer Blick auf die Maschine hinter der Kunst:

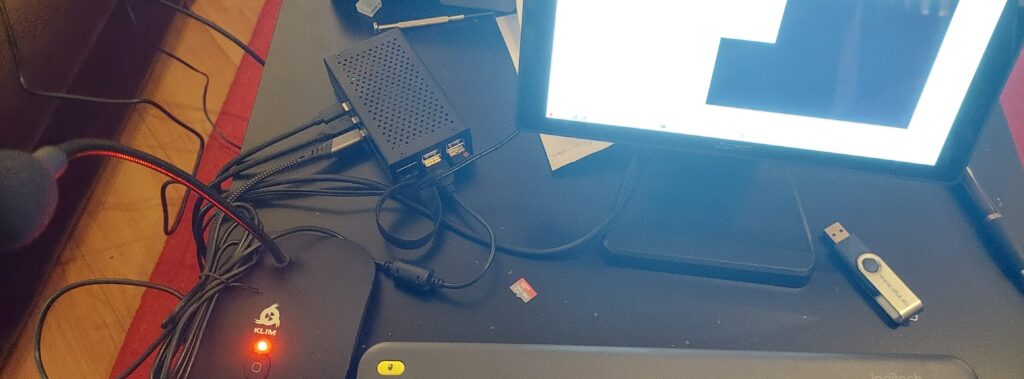

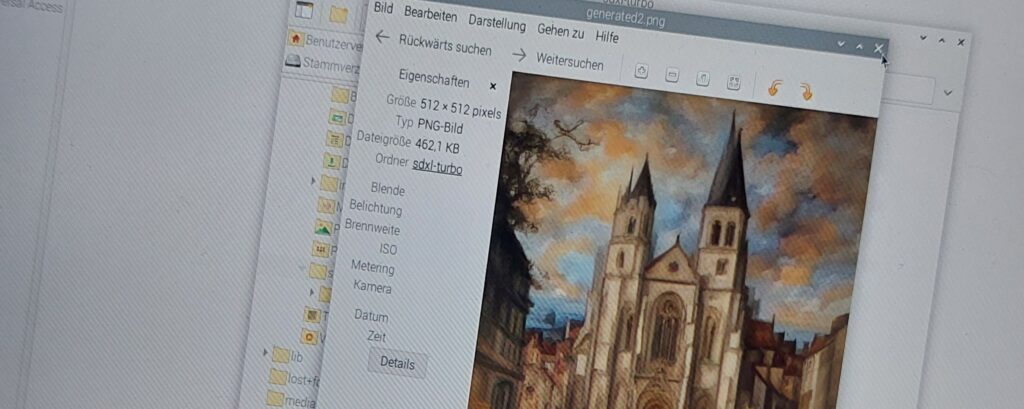

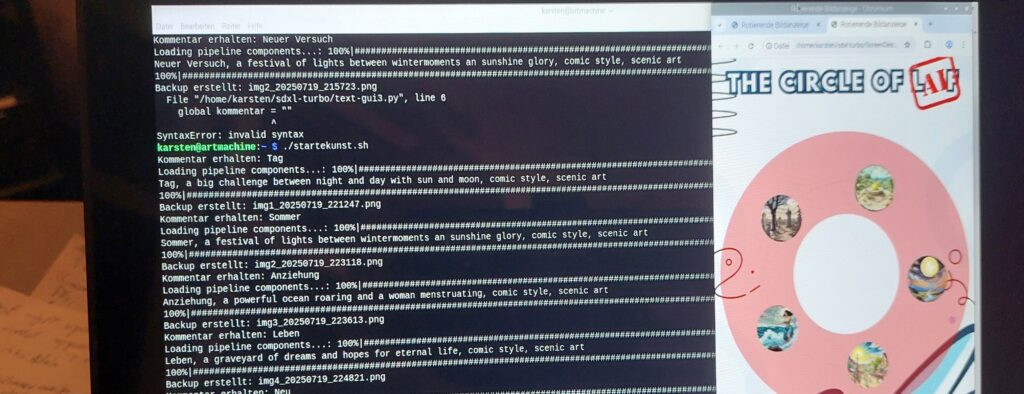

Meine „artmachine“ ist ein Raspberry Pi 5, ein Minicomputer, der auf Debian-Linux basiert und für automatisierte Aktivitäten optimiert ist. Angeschlossen ist nach Plan nur ein großes Display. Dort werden die KI-generierten Ergebnisse der Publikumsinteraktion dargestellt. Aber kann man überhaupt bildgebende KIs auf einem Einplatinencomputer ohne externe Grafikkarte betreiben? Kurze Antwort: Jein! Eigentlich reicht laut einiger Berichte sogar ein Pi Zero (also die Minimalversion des kleinen Bruders) aus, aber dann macht das Ganze keinen Spaß. Und ursprünglich habe ich das Hailo-8L AI Kit gekauft, um einen externen NPU für die KI-Aufgaben zu haben. Leider hatte ich schlampig recherchiert und erst später rausgefunden, dass dieses Kit zwar KI-Aufgaben in der Bilderkennung übernehmen kann, aber eben keine LLMs unterstützt. Also läuft meine KI nur auf der CPU und das reizt das System natürlich ganz gut aus. Aber ich habe etwas experimentiert, mit den Parametern und kommandozeilenbasierten LLMs gespielt und bin bei Stable Diffuion XL-Turbo hängen geblieben. Damit kann ich eine Teilgrafik in 2-3min komplett lokal erzeugen. Und weil ich nicht den gesamten FullHD-Monitor generiere, sondern 5 Elemente abwechselnd erzeugt werden, reicht es vollständig aus, in jedem Gang 512×512 Pixel große Bilder zu erzeugen. Wenn nächstes Jahr eine LLM-taugliche M2-Extention rauskommt, kann man da ggf upgraden, aber fürs erste bin ich zufrieden.

Und 3min ist auch die Zeit, die ich eingeplant habe. Ca. 3min dauern die Lesungen, die zum Nachdenken einladen und am Ende eine Textbox öffnen. Mit der Eingabe dauert dann die Generierung nochmal ca. 3min, während die Zuschauer über die verschiedenen Visualisierungsgedanken ins Gespräch kommen können. Wenn dann das Bild zum eigenen Prompt generiert ist, beginnt der nächste Zyklus.

Da es fünf Texte gibt kann man sich also in 6-8min mit einem Text beschäftigen oder in 30-60min alle 5 Themen durchgehen, um den ganzen Zyklus zu bedenken.

Durch die fehlende NPU wird das gleichzeitige Anzeigen einer Vollbildpräsentation, des Textvideos und die KI-Berechnung aber auf einem Pi nicht laufen. Daher kommt noch ein Pi 4 zum Einsatz, auf dem dann die Videos und Bilder angezeigt werden, während der Pi 5 nur für die KI-Berechnung reserviert bleibt. Ggf hätte ich noch einen alten Pi 3 rumliegen, der zumindest eine Slideshow der bisherigen Bilder anzeigen könnte. Da muss ich nochmal prüfen, welche Kombination für welchen Zweck am Besten geeignet ist. Aus einer artmachine sind also 2-3 Maschinen geworden, die Hand in Hand dazu führen, dass ein innovatives Kunstprojekt Realität wird. Aktuell teste ich es auf Herz und Nieren, damit ab dem 31.7. bei der Premiere beim Freakstock alles funktioniert.

Wichtig ist mir, dass alle Prozesse offline möglich sind, um datentechnisch save zu sein und unabhängig von Funkmasten etc. Zwar ist eine Feedbackmöglichkeit vom eigene Handy über ein Onlineformular eine nette Option, aber auch ohne diese Schnittstelle soll eine rein lokale Variante funktionieren und zeigen, das KI-Kunst auch ohne kommerzielle Anbieter mit vernebelten Trackingzielen funktionieren kann.

Perspektivisch will ich übrigens auch noch mit anderen LLMs, mit Spracherkennung und Bildverfremdung experimentieren. Schon alleine, um den tollen KI-Chip (immerhin mit 26 TOPS) mal einzusetzen. Also z.B. eine Fotobox, in der man sein Lieblingstier nennt und dann ein Foto bekommt, in dem man das Gesicht seines Lieblingstieres bekommt. Oder ein Fußballvideo in dem alle als Dinosaurier dargestellt werden? Mal schaun, was mir noch einfällt…

In jedem Fall sind solche Kunstprojekte auch immer tolle Möglichkeiten, mit Menschen über pro und cotra von KI-Kunst zu reden, denn natürlich möchte ich nicht unterstützen, dass in Zukunft keine Künstler mehr bezahlt werden, um z.B. Grafik/Musik/Videos/Webseiten zu erstellen, aber eine KI-lose Gesellschaft wird es wohl auch nicht mehr geben, daher müssen wir lernen, wo wir menschliche Kreativität und Kunstfertigkeit und die Produktivität von KI bei Standardarbeiten gut kombinieren können. Hinter der artmachine steht also auch die Frage: In was für einer Welt wollen wir leben?